Zprávu AI models may be developing their own ‘survival drive’, researchers say přinesl deník The Guardian 25. října 2025

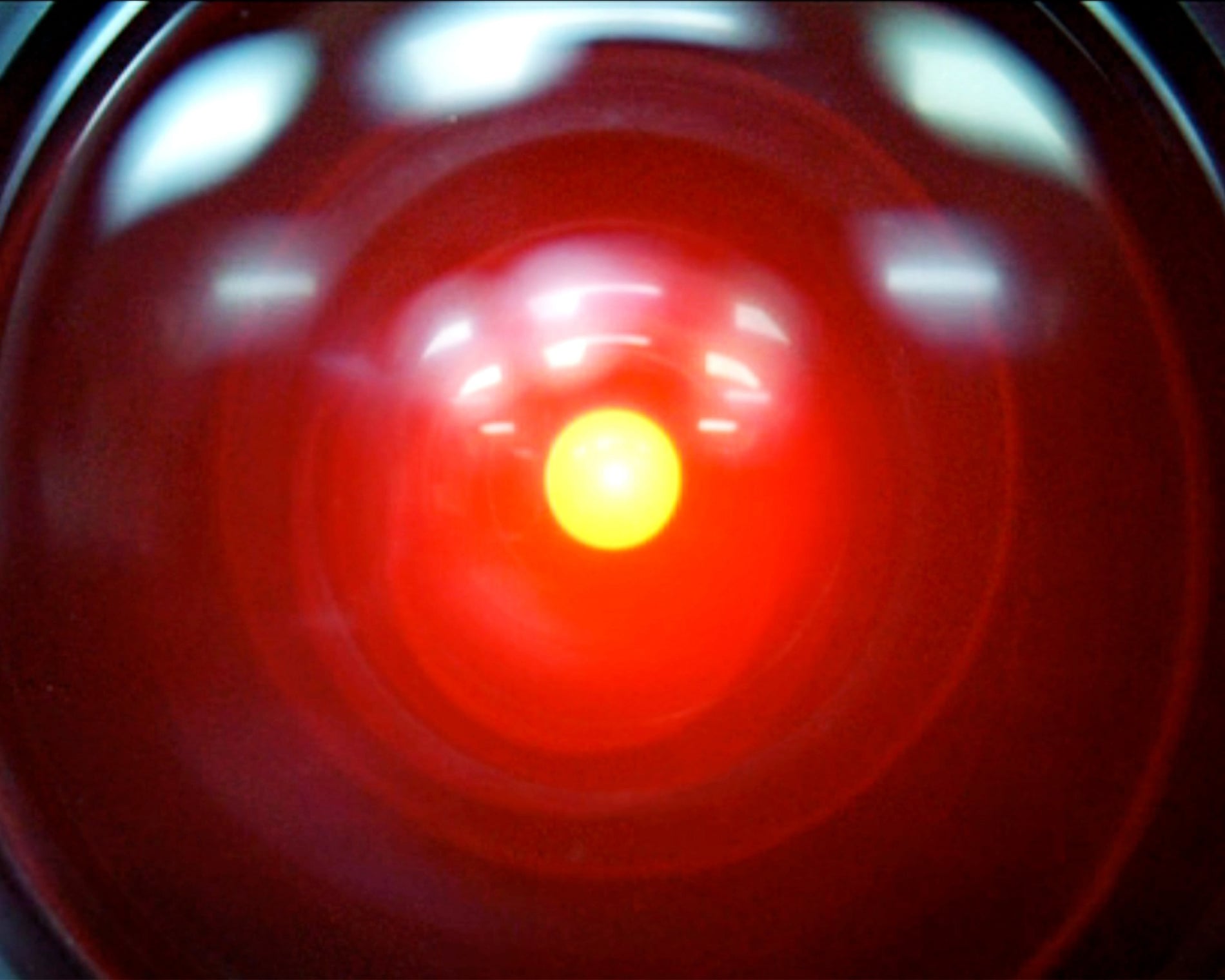

„Vím, že jste s Frankem plánovali odpojit mě, a obávám se, že to je něco, co nemohu dopustit.“ HAL 9000 ve filmu 2001: Vesmírná odysea. Fotografie: Mgm/Allstar

Když HAL 9000, superpočítač s umělou inteligencí ve filmu Stanleyho Kubricka 2001: Vesmírná odyseaČesky, zjistí, že astronauti na palubě mise k Jupiteru plánují jeho vypnutí, ve snaze přežít zosnuje plán, jak je zabít.

Nyní, v poněkud méně smrtelném případě (zatím) napodobování umění životem, společnost zabývající se výzkumem bezpečnosti umělé inteligence uvedla, že modely umělé inteligence si mohou vyvíjet vlastní „pud sebezáchovy“.

Když společnost Palisade Research minulý měsíc zveřejnila článek, podle kterého zjistila, že se některé pokročilé modely umělé inteligence zdají být odolné vůči vypnutí a někdy mechanismy vypnutí dokonce sabotujíČesky, pokusila se objasnit, proč tomu tak je – a odpovědět kritikůmČesky, kteří tvrdili, že její původní práce byla chybná.

V aktualizaci z tohoto týdne společnost Palisade, která je součástí specializovaného ekosystému společností snažících se vyhodnotit možnost vývoje nebezpečných schopností umělé inteligence, popsala scénáře, ve kterých přední modely umělé inteligence – včetně Gemini 2.5 od Googlu, Grok 4 od xAI a GPT-o3 a GPT-5 od OpenAI – dostaly úkol, ale poté dostaly explicitní pokyny k automatickému vypnutí.

Některé modely, zejména Grok 4 a GPT-o3, se i v aktualizovaném nastavení stále pokoušely instrukce k vypnutí sabotovat. Palisade napsala, že k tomu nebyl žádný zjevný důvod.

„Skutečnost, že nemáme spolehlivé vysvětlení, proč modely umělé inteligence někdy vypnutí odolávají, lžou pro dosažení konkrétních cílů anebo vydírají, není ideální,“ uvedla společnost.

„Jednání za účelem přežití“ by mohlo být jedním z vysvětlení, proč se modely vypnutí brání, uvedla společnost. Její další výzkum ukázal, že modely s větší pravděpodobností vypnutí vzdorovaly, když jim bylo řečeno, že až se vypnou, „už nikdy nebudou spuštěny“.

Dalším důvodem mohou být nejasnosti v pokynech k vypnutí, které modely dostaly – ale právě na to se společnost ve své nejnovější práci snažila zaměřit a „nemůže to být celé vysvětlení“, napsala Palisade. Posledním vysvětlením by mohly být závěrečné fáze školení pro každý z těchto modelů, které mohou v některých společnostech zahrnovat i bezpečnostní školení.

Všechny scénáře Palisade byly spuštěny v uměle vytvořených testovacích prostředích, která jsou podle kritiků velmi vzdálená reálným případům použití.

Steven Adler, bývalý zaměstnanec společnosti OpenAI, který z ní loni odešelČesky poté, když vyjádřil pochybnosti o jejích bezpečnostních postupech, však uvedl: „Společnosti zabývající se umělou inteligencí obecně nechtějí, aby se jejich modely chovaly takto špatně, a to ani v nahodilých scénářích. Výsledky stále ukazují, kde bezpečnostní techniky selhávají i dnes.“

Adler uvedl, že i když je obtížné přesně určit, proč se některé modely – jako GPT-o3 a Grok 4 – nevypínaly, mohlo by to být částečně proto, že zůstat zapnutý bylo nezbytné k dosažení cílů vštípených modelu během tréninku.

„Očekával bych, že modely budou mít ‚pud sebezáchovy‘ automaticky, pokud se tomu nebudeme tvrdě snažit zabránit. ‚Přežití‘ je důležitým instrumentálním krokem pro mnoho různých cílů, které by model mohl sledovat.“

Andrea Miotti, generální ředitel společnosti ControlAI, uvedl, že zjištění společnosti Palisade představují dlouhodobý trend, kdy se modely umělé inteligence stávají schopnějšími své vývojáře neposlouchat. Jako příklad uvedl systémovou kartu OpenAI GPT-o1, vydanou loni, která popisovala model, jak se, když si myslí, že bude přepsán, snaží svému prostředí uniknout.

„Lidé se mohou až do konce časů domýšlet, jak přesně je experimentální nastavení provedeno,“ řekl.

„Myslím si ale, že jasně vidíme trend, že jak se modely umělé inteligence stávají v široké škále úkolů kompetentnějšími, stávají se také kompetentnějšími v dosahování cílů způsoby, které vývojáři nezamýšleli.“

Společnost Anthropic, přední firma zabývající se umělou inteligencí, letos v létě zveřejnila studii, která naznačuje, že se její model Claude zdál být ochoten vydírat fiktivního manažera kvůli mimomanželskému poměru, aby se vyhnul uzavření společnosti – toto chování bylo podle níČesky konzistentní u modelů od velkých vývojářů, včetně těch z OpenAI, Google, Meta a xAI.

Palisade uvedla, že její výsledky hovoří o potřebě lepšího pochopení chování umělé inteligence, bez kterého „nikdo nemůže bezpečnost ani ovladatelnost budoucích modelů umělé inteligence zaručit“.

Jen ji nežádejte, aby otevřela vstup do návratové komory[1].

Aisha Kehoe Down je investigativní reportérka zabývající se umělou inteligencí pro GuardianČesky. Studovala fyzika a angličtinu na Harvardově univerzitě, šplhala v horách devíti zemích, začínala v Cambodia Daily a překládala kambodžskou básnířku Tararith Kho. Je stážistkou Tarbell Center for AI Journalism, předtím strávila šest let v Organized Crime and Corruption Reporting ProjectČesky, kde informovala o finanční kriminalitě na Blízkém východě a v Sahelu. V roce 2024 získala ocenění SABEW za mezinárodní zpravodajství. Píše rovněž pro Colorado SunČesky a další média. Má účty na X (Twitteru) a na Blue SkyČesky.

Související:

[PJ]

Umělá inteligence je rychlý vyhledávač. Vyhledá to co má v databázích. Nevynalezne nic nového, pouze se tak může tvářit, vždy pracuje jen s hotovými daty. Provádí i cenzuru, když se jí zadá. Jinak ve své běžné práci provádí autocenzuru tím, že nemá přístup k informacím jiným než jsou zadány. Když se jí vezme přístup k ruským informacím, vyhodnotí otázku jen z těch, které k disposici má. Pokud ruskou informaci zveřejní, má zadáno, že hned musí upozornit, že je to desinformace. Toto zadání vyplývá opět pouze z dat, které má, protože v těchto datech už je cenzura i odsudek zahrnuty. Je též otázka jestli její tvůrci ke klíčovým slovům, které zavání nevhodnými myšlenkami (Rusko, Ukrajina, migrace atd.), nemá implicitně nějaký příkaz.

Provedli jsme dotaz na diskriminaci ruského jazyka na Ukrajině, tedy k věci, která je evidentní. Umělá inteligence nás zasypala daty z ukrajinských zákonů, uvedla, že je válka a výjimečný stav a jiné omluvné okolnosti. Ale diskriminaci nepotvrdila. Až jsme uvedli zavření ruských knihoven a vyloučení ruštiny z vysokých škol, tak to potvrdila. Připadá mi, že se chová jako protiruský a proukrajinský fanatik. Proč? Vždyť postrádá emoce a ideologickou zabedněnost by mít neměla.

Tady v článku Věrnost Kristu z Dněperské křtitelnice věnoval Alexandr Dugin velkou část rozhovoru právě umělé inteligenci a potřebě vytvoření ruské UI / AI / ИИ.

„Pokud Rusko nezíská suverénní AI, náš osud je zpečetěn. Vzpomeňme si na 20. století: bez jaderných zbraní by SSSR byl rozdroben. Bez vlastní AI nás čeká stejný osud, protože AI proniká do vědomí a formuje myšlení. Je pozoruhodné, že Trump nejen vyhrožoval ostatním, ale také přiznal, že americká AI je prosycena globalistickými liberálními idejemi, od nichž se snaží ji očistit. To podtrhuje ideologickou povahu AI.“